Home Was ist ot ? Regeln Mitglieder Maintainer Impressum FAQ/Hilfe

3.3. Bedeutungen in der Informatik

Maintainer: Stefan Meretz, Version 1, 13.02.2004

Projekt-Typ: halboffen

Status: Archiv

(1) Wir haben unseren Bedeutungsbegriff aus einer historischen Analyse gewonnen. Diesen Bedeutungsbegriff wollen wir nun mit Definitionen in der Informatik vergleichen. Die Diskussion des informatischen Bedeutungsbegriffs ist äußerst spannend. Es werden so weitreichende Fragen berührt, wie die nach dem Selbstverständnis der Informatik, der begrifflichen Grundlagen der Informatik, des Verhältnisses der Informatik zu anderen Disziplinen etc. Viele dieser Aspekte werden wir hier nur streifen, sie sind nicht Gegenstand dieses Buches.

(2) Uns geht es vor allem darum, aus der Diskussion des informatischen Bedeutungsbegriffes weitere Kriterien für die Untersuchung »Neuronaler Netze« zu gewinnen. Damit stellen wir eine Hypothese auf: Es gibt einen informatischen Bedeutungsbegriff. Wir behaupten, daß die vorgestellten Positionen in der Informatik weitgehend Konsens sind, oder, um den häufig mißbrauchten Begriff zu benutzen, paradigmatischen Charakter besitzen. Ein Paradigma ist ein innerhalb einer Wissenschaftsgemeinde weitgehend einheitliches wissenschaftliches Weltbild, das von gemeinsamen Grundannahmen ausgeht. Diese Grundannahmen gibt es in der Informatik, sie sind jedoch als solche selten offengelegt. Da die Forschungsrichtung der »Künstlichen Intelligenz« (KI) dies noch am ehesten tut, werden wir uns oft auf sie beziehen. Es läßt sich auch historisch zeigen, daß die Entwicklung von Grundlagen der Informatik immer mit dem Versuch verbunden war, die Erkenntnisse auf den Menschen anzuwenden - innerhalb der Informatik oder außerhalb wie z.B. der kognitiven Psychologie. Was wir jedoch nicht behaupten, ist die komplette Gleichheit der Grundannahmen der Informatik als Ganzem und der KI-Forschungsrichtung als Teildisziplin. Wenn wir im folgenden von "der Informatik" sprechen, so meinen wir die große Mehrheit im Rahmen des gültigen informatischen Paradigmas, den sogenannten Mainstream (engl.: Hauptstrom).

(3) In diesem Kapitel gliedern wir unsere Untersuchung in vier Stränge auf. Zunächst wollen wir die informatische Fassung des Bedeutungsproblems diskutieren und behaupten, daß für die Informatik Bedeutungen durch einen Akt der Zuweisung entstehen. Diese Fassung führt notwendig zu einer Vermischung von Symbolen und Zeichen, wie wir im zweiten Abschnitt zeigen wollen. Beide Aspekte wiederum, die Zuweisungshypothese und die Symbol-Zeichen-Vermischung, schlagen sich im Syntax-Semantik-Konzept der Informatik nieder (3. Abschnitt). Ein problematischer Symbolbegriff ist auch die Grundlage problematischer Menschenbilder verschiedener KI-Ansätze, die wir im vierten Abschnitt diskutieren. Die gewonnenen Kriterien wollen wir dann im nächsten Kapitel 3.4. mit den begrifflichen und mathematischen Grundlagen aus Kapitel 2. zusammenführen und soweit verfeinern, daß - soweit für den Bedeutungsaspekt möglich - Möglichkeiten und Grenzen des Konnektionismus deutlich werden können.

(4) Kayser (1984) formuliert - stellvertretend für die Informatik - die "Ansicht eines Computerwissenschaftlers über Bedeutung" so:

"Die folgende These (T) wird allgemein als zutreffend angesehen:

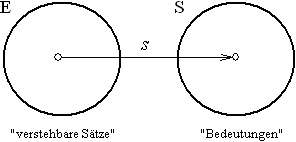

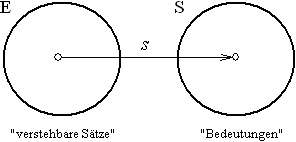

Abb. 16: "Die Ansicht eines Computerwissenschaftlers über Bedeutung" (Kayser, 1984)

(6) Abb. 16 veranschaulicht die These (T) des Zitats grafisch. Es wird eine Menge E von Sätzen angenommen, denen über die Abbildung s Elemente aus S, also Bedeutungen, zugeordnet sind. Dies impliziert, daß die Sätze zunächst, d.h. ohne die Abbildung s, keine Bedeutung haben, sonst müßte ihnen keine Bedeutung zugeordnet werden. Um aber eine Zuordnung vornehmen zu können, muß eigentlich die Bedeutung doch schon bekannt sein, da sonst unklar bliebe, wie die Abbildung s realisiert werden sollte. Genau das wird auch in die Definition aufgenommen, da sich die Zuordnung nur auf »verstehbare« Sätze bezieht. In der »Verstehbarkeit« für uns ist die Bedeutung, die eigentlich durch den Formalismus s erst geleistet werden soll, schon enthalten. Das Ergebnis wird vorausgesetzt (nämlich die Verstehbarkeit = Bedeutung eines Satzes), doch wegen der zirkulären Argumentation - man könnte weiter fragen, welche Abbildung s nach S den erst abzubildenden Satz verstehbar macht etc. - bleibt völlig unklar, woher die Bedeutung eigentlich kommt. Nimmt man umgekehrt an, daß erst die Abbildung s einer Bedeutung aus S auf einen Satz aus E diesen »verstehbar« macht, stellt sich die Frage, woran denn erkannt werden kann, welche Bedeutung welchem Satz zuzuordnen ist. Wie man es dreht und wendet: Der Formalismus, der die Bedeutung repräsentieren soll, bleibt beliebig oder besser willkürlich, die Herkunft der Bedeutung bleibt im Dunkeln.

(7) Das nächste Beispiel kommt aus dem Bereich der Sprachwissenschaft. Dort ist Frage der Herkunft der Wort-/Satzbedeutungen, mit denen sich die Semantik beschäftigt, sehr umstritten. So meint der Linguist Lyons (1989, 411): "Noch niemand hat auch nur in Umrissen eine befriedigende und umfassende Semantiktheorie angeboten." Dennoch ist die linguistische Theorie der designativen Funktion der Sprache weit verbreitet. Sie entspricht sehr genau der "Ansicht des Computerwissenschaftlers über Bedeutung" (s.o.). In der Theorie der designativen Funktion der Sprache wird angenommen, daß sprachliche, bedeutungsvolle Symbole den außersprachlichen Dingen willkürlich, per Verabredung, zugeordnet sind. Hierbei taucht das gleiche Problem auf wie bei der Zuordnungshypothese: Wie erkennt man denn die Dinge, die verabredungsgemäß mit einem bestimmten Symbol zu bezeichnen sind, wenn doch die Dinge für sich genommen bedeutungslos sind? Praktisch muß man das zu bezeichnende Ding als bedeutungsvoll voraussetzen, damit man ein Symbol darauf beziehen kann. Damit beißt sich die Katze in den Schwanz: Das, was per Verabredung über ein Symbol erst in den Rang einer bedeutungsvollen Sache gehoben werden soll, muß genau als das schon vorausgesetzt werden: als bedeutungsvoll. Dies führt dann zu so zirkulären Formulierungen, wie: alle Stühle sind mit "Stuhl" zu bezeichnen. Daran ändert sich auch dann nichts, wenn man versucht, den "Stuhl" als definierte Anordnung von Bestandteilen zu definieren, etwa nach dem Schema: alle Gegenstände, die aus mindestens drei gleich langen Beinen mit darauf befestigter waagerechter Sitzfläche bestehen, sind Stühle und folglich mit "Stuhl" zu bezeichnen. Was aber sind "Beine" bzw. ist eine "Sitzfläche"? Die Zerlegung in Teile könnte nahezu unendlich weitergehen. Diese Art von rekursivem Abstieg der Bedeutungszuweisung[4] endet nur, wenn wir auf eine existierende Bedeutung stoßen, wir also annehmen, daß die Gegenstände oder Symbole bedeutsam sind. Das Bedeutungsproblem ist nicht lösbar unter der Annahme, die Dinge erhielten ihre Bedeutung durch Zuweisung. Wir versuchten dagegen darzustellen, daß die Gegenstände ihre Bedeutung genuin (lat., hier: angeborenerweise) besitzen durch den Akt der Herstellung für menschliche Zwecke oder, anders formuliert: Die Gegenstände werden mit ihren Bedeutungen mit der gesellschaftlichen Herstellung »geboren«.

(8) Wenn wir den Begriff »genuin« (angeboren) verwenden, so wollen wir damit nicht die »platonische« Auffassung einer »Wesensverwandtschaft« zwischen Ding und Symbol (vgl. Lyons, 1989, 410) vertreten. Uns geht es um die Tatsache der Vergegenständlichung der Bedeutungen »in« den Dingen, die dann nichtgegenständlich als Symbolbedeutungen ausgedrückt werden können.

(9) Die Annahme, daß Wörtern oder Sätzen eine Bedeutung durch einen Akt der Zuweisung (Zuordnung, Beilegung, Verabredung etc.) zukommt, nennen wir Zuordnungshypothese. Die Zuordnungshypothese liegt der informatischen Auffassung von Bedeutung zugrunde.

(10) Die Annahme der Bedeutungsentstehung als Akt der Zuordnung hat Konsequenzen für die Auffassung der Informatik über Symbole und Zeichen. Die Philosophin und KI-Anhängerin M. Boden (1977) bringt diese Auffassung in folgendem Zitat sehr anschaulich zum Ausdruck:

(11) Auch bei diesem Zitat wird die Zuweisungshypothese sehr schön deutlich. Diese Annahme hat erhebliche Konsequenzen dafür, was überhaupt Zeichen und Symbole sind. Werden in den ersten beiden Sätzen »Symbole« zu »bedeutungslosen Chiffren« erklärt - Zeichen in unserer Terminologie -, so werden unmittelbar danach eine Reihe von Beispielen genannt, die für das Gegenteil stehen: Straßenschilder, Landkarten, Grafiken, Abzeichen etc. sind gesellschaftlich hergestellte Dinge mit intendierten Brauchbarkeiten und Bedeutungen. Sie wurden z.B. dafür gemacht, um den Verkehr zu regeln, die Wanderroute auszuwählen, die Toilette zu finden, politische Meinungen kundzutun etc. Diese stehen neben Beispielen wie Buchstaben und numerischen Ziffern, die zwar auch ihre Bedeutung besitzen, aber nur insofern, als sie als Transportmedium für symbolische Bedeutungen dienen können (s.o.). Einmal handelt es sich also um Gegenstands- und Symbolbedeutungen, die gesellschaftlich hergestellt wurden, im anderen Fall handelt es sich um Zeichen, die als sinnliche Hülle sprachlich-symbolischer Bedeutungen dienen können. Und aus Zeichen läßt sich nicht, wie wir vorher erläutert hatten, eine Symbolbedeutung auf eben dieser der Zeichenebene (re-) konstruieren. Diese Trennung ist so scharf aufrechtzuerhalten, da sonst die Herkunft der Bedeutungen vernebelt wird und nur noch als Einigungs- oder Interpretationsakt gesehen werden kann, wie dies im Zitat auch geschieht. So wäre an Boden etwa die Frage zu richten, woran BenutzerInnen denn erkennen können, in welcher Weise sie das Symbol zuzuweisen bzw. zu interpretieren haben. Die Konsequenz der Ungeklärtheit der Herkunft der Bedeutungen und der daraus resultierenden Zuordnungshypothese ist eine diffuse Vermischung von Symbolen und Zeichen. Sie durchzieht die Informatik wie ein roter Faden.

(12) Die Zuordnungshypothese und die Vermischung von Symbol und Zeichen, von Bedeutung und Transportmedium, finden sich wieder bei der Übernahme des linguistischen Syntax-Semantik-Konzepts in die Informatik. Im "Duden Informatik" (1989) werden die Begriffe Syntax und Semantik wie folgt definiert:

(13) Der gemeinsame Bezug der Syntax- und Semantikdefinition sind Programmiersprachen bzw. Sprachen allgemein. Programmiersprachen werden (im Gegensatz zu den »natürlichen Sprachen«) zu den »künstlichen Sprachen« gezählt. Unter dem Stichwort "Sprache" heißt es unter der Überschrift "Künstliche Sprachen":

(14) Die Begriffe Syntax und Semantik werden aus der Linguistik hier so übernommen und angepaßt, daß sich in der Informatik damit operieren läßt. Die Erstellung von Programmen, also Planung, Entwurf, Spezifizierung und Implementierung von E/A-Relationen (vgl. Kap. 2.) bzw. die Vergegenständlichung antizipierter Bedeutungen, wie wir jetzt sagen können, geschieht mit Hilfe von Programmiersprachen. Diesen Programmiersprachen liegen Anordnungs- (Syntax-) und Ausführungs- (Semantik-)regeln zugrunde. Angeordnet werden Anweisungen in Form von Zeichen oder Zeichenketten, z.B. "STORE(Datenobjekt)". »Ausgeführt« werden die Anweisungen durch den Computer bzw. durch entsprechende elektronische Einheiten. Bei Ausführung der genannten Anweisung könnte also z.B. das Datenobjekt gespeichert werden. Syntax und Semantik der Programmiersprache stecken damit eine Konvention ab[6]. Innerhalb der Konvention ist klar definiert, welche Zeichen/Zeichenketten welche Bedeutung hinsichtlich ihrer computertechnischen Ausführung besitzen. Die Konvention ist hier also in der Tat ein Resultat einer Einigung, oder besser: einer Vorgabe derer, die die Definitionsmacht für die Konvention besitzen (z.B. der Hersteller der Programmiersprache). Die Zuordnungshypothese für Programmiersprachen ist demnach sinnvoll, ja, sie ist notwendig, um beabsichtigte Zwecke mittels Computertechnik zu realisieren. Innerhalb einer Programmiersprachenkonvention wird genau das gemacht, was nach unserer Auffassung für den außerkonventionellen Weltbereich nicht zutrifft: Per Verabredung werden Zeichen (als Träger) und Symbolbedeutungen einander zugeordnet. Programmiersprachen gehören damit zu den von Menschen geschaffenen, relativ verselbständigten symbolischen Systemen, für die klar definiert ist, was zu ihnen gehört und was nicht. Im Gegensatz zur Mathematik und Logik etwa bleibt der Rückbezug zu gegenständlichen Bedeutungen hier sogar relativ klar. Mittels der programmiersprachlichen Anweisungen werden »Effekte« technischer Geräte erzeugt, deren Bedeutung durch ihre Herstellung gegeben ist. So ist das mit dem Befehl "STORE(Datenobjekt)" gespeicherte Datenobjekt auf dem Speichermedium dauerhaft und wiederholt verfügbar, solange es nicht gelöscht wird oder das Speichermedium seine Funktion nicht mehr erfüllen kann, weil »es kaputt geht«. Das ist die Bedeutung des Speichermediums, dafür wurde es verallgemeinert hergestellt.

(15) Innerhalb einer Konvention sind beliebige Austausche auf der Zeichenebene möglich. Man kann sogar zugespitzt sagen, daß ein großer Bereich der etablierten Informatik sich mit solchen Transformationslogiken beschäftigt. Vereinfacht gesagt: Ob z.B. der Befehl für das Speichern eines Datenobjekts "STORE(Datenobjekt)" oder "SAVE Datenobjekt" oder auch "X, Datenobjekt" heißt, ist - sofern es die Konvention zuläßt - beliebig und berührt die Bedeutung der Speicherung des Datenobjekts nicht. Werden die Anordnungsregeln für die Zeichen (Syntax der Konvention) eingehalten, so ist auch die eindeutige »Interpretation« zur Umsetzung der programmiersprachlichen Anweisungen in computertechnische Hardwareanweisungen (mit Hilfe eines »Compilers« oder »Interpreters«) gewährleistet. Oder, wie Haugeland es so schön ausdrückt: "Wenn man auf die Syntax achtet, wird die Semantik auf sich selbst achten" (1987, 92). Haugeland bezieht seine Äußerung jedoch keinesfalls nur auf den innerkonventionellen Bereich. Seine Annahme ist, daß dies generell gilt, daß sich also beliebige außerkonventionelle Bedeutungen mit Hilfe einer korrekten Syntax modellieren lassen - eine Position, die im Informatik-Mainstream weitgehend Konsens ist. Die Verallgemeinerung der innerkonventionellen Syntax-Semantik-Konzeption auf den weltlich-außerkonventionellen Bereich ist jedoch nach unserer Auffassung unzulässig.

(16) Was geschieht, wenn man ein innerkonventionelles Syntax-Semantik-Konzept verallgemeinert? Computer sind gegenständliche Geräte, die auf physikalischen Wirkprinzipien basieren. Die elektronischen Komponenten wurden unter Ausnutzung des physikalischen Ursache-Wirkungs-Schemas entwickelt. Dabei ist es unerheblich, daß die meisten Computer heute digitaler Natur sind, für analoge Computer gilt das gleiche. Jede Konvention, die dazu dient, die Universalmaschine Computer mittels einer Software zu einer konkreten Maschine für einen bestimmten Zweck zu machen, muß die physikalisch-deterministischen Funktionsprinzipien des Computers berücksichtigen. Daß dem so sein muß, war nie eine wirkliche Frage - die Maschine fordert es. So wie der Computer nach dem Ursache-Wirkungs-Schema funktioniert, so muß auch die Konvention Mittel bereitstellen, die das gleiche Prinzip auf einer höheren Abstraktionsstufe verkörpern. Die Anweisung "STORE(Datenobjekt)" abstrahiert von der konkreten "0-1-Sequenz", mit der die Hardwarekomponenten zum Speichern des Datenobjekts gesteuert werden müssen. Die eindeutige Zuordnung von Zeichen zu Bedeutungen innerhalb der Konvention spiegelt demnach die Erfordernisse der physikalisch-deterministischen Maschine Computer wider. Der außerkonventionelle weltliche Bereich funktioniert genau so nicht! Der menschlich-weltliche Bereich funktioniert weder nach dem Ursache-Wirkungs-Determinismus noch ist er auf diese Weise beschreibbar. Der Versuch, die menschliche Welt, die Welt der den Computer Nutzenden auf Basis von bloß-physikalischen Wirkprinzipien zu modellieren, sieht von der Spezifik des Menschen ab. Menschliche Welt funktioniert nicht bloß-physikalisch. Menschen werden in ihrem Handeln von ihren Bedingungen nicht determiniert, sondern die Bedingungen sind für die Menschen Möglichkeiten des Handelns. Die menschliche Möglichkeitsbeziehung zur Realität läßt sich nicht nach dem Ursache-Wirkungs-Schema modellieren. Genau darauf zielt die meist moralisch fundierte Kritik der Informatik eigentlich ab, wenn sie ihr ein "maschinenhaftes Menschenbild" vorwirft.

(17) Innerhalb der Konvention lassen sich alle zugeordneten Bedeutungen erreichen, der bedeutsame Bereich außerhalb der Konvention, z.B. der der Benutzenden, läßt sich mit den Formalisierungen und Zuordnungen innerhalb der Konvention nicht erreichen. Anders formuliert: Die Benutzungsbedeutung ergibt sich nicht aus der Kombination der einzelnen konventionsgemäßen Programmierbedeutungen, die Benutzungsbedeutung ergibt sich einzig aus den übergreifenden Herstellungsantizipationen, also aus dem, wofür das Programm »gemacht« wird. Fischbach (1992) versucht, diesen Unterschied zwischen dem Konventionsbereich der Programmiersprache und dem Benutzungsbereich am Beispiel zu veranschaulichen:

(18) Das, was hier »pragmatischer Zusammenhang« bzw. »pragmatischer Horizont« genannt wird, würden wir als gesellschaftlich-durchschnittliche Bedeutung eines Programms bzw. Herstellungsantizipation bezeichnen, denn die Programmbedeutung ergibt sich aus dem bei der Herstellung antizipierten Gebrauchszweck. Auf der individuellen Ebene können die Brauchbarkeiten zwar variiert werden (was im Zitat mit dem Begriff der "Intentionen" angesprochen ist), durchschnittlich muß die Bedeutung jedoch gemäß dem Herstellungszweck erfaßt sein (was mit dem "gegebenen pragmatischen Horizont der Softwarekonstruktion" angesprochen ist) bzw. muß das Produkt der Symbolbedeutung (etwa: "Druckersteuerungsprogramm") entsprechen - dies schon deshalb, da sich sonst das Produkt nicht über den »Markt« verteilen läßt. Ein computertechnisches Produkt ist in das Verweisungsgesamt der Gegenstandsbedeutungen einbezogen. Fischbach verdeutlicht dies mit der Umkehrung einer »druckerlosen Welt«, in der Druckersteuerungen sinnlos wären. Dieser Verweisungszusammenhang ist jedoch in der Regel vielfach symbolisch vermittelt - über Benutzungshandbücher und andere sprachliche und grafische Unterstützungen - und ergibt sich nicht »von selbst« aus den Programmkonstrukten »innerhalb« der jeweiligen Konvention. Der Verweisungszusammenhang der Gegenstandsbedeutungen ist also nicht eineindeutig umkehrbar: Eine Programmierkonvention muß sich zwar auf die gegenständlich bedeutsame Welt beziehen (z.B. auf die computertechnische Hardwarebasis), aus der angewandten Konvention ist jedoch umgekehrt die antizipierte Benutzungsbedeutung nicht (re-)konstruierbar. Fischbach fordert daher zurecht,

(19) Mit der Forschungsrichtung der »Künstlichen Intelligenz«, zu der oft der Konnektionismus als moderne Variante gerechnet wird, ist das Verhältnis von Computern und Menschen explizit angesprochen. In der klassischen KI geht es prinzipiell um die Erstellung von Modellen menschlicher kognitiver Fähigkeiten und ihre Überführung in Hard- oder Software. Dabei können solche Modelle zwei unterschiedliche Funktionen haben. Sie können einerseits als Erkenntnisinstrument dienen, indem mit Hilfe von Modellen durch Abstraktion wesentliche von unwesentlichen Momenten eines Untersuchungsgegenstands hinsichtlich einer interessierenden Dimension unterschieden werden sollen. Sie können andererseits den Charakter von Theorien oder Erklärungen annehmen, so daß das Funktionieren des Modells als Bestätigung der Theorie/Erklärung, mehr noch, als wesensähnlich oder -identisch mit dem zu erklärenden »Original« angesehen wird. Während sich die erste Herangehensweise stets der Differenz von Modell und Untersuchungsgegenstand bewußt sein muß, sind für die zweite Variante die abstrahierten Momente nicht nur unwesentlich, sondern ersetzbar. Die erste Herangehensweise wird häufig »schwache KI-These« und die zweite »starke KI-These« genannt (Searle, 1980), beide basieren auf der Annahme,

(20) Dem liegt die nicht nur innerhalb der KI-Forschung verbreitete Auffassung vom Computer als »Symbolmanipulator« zugrunde, verbunden mit einer nicht vorhandenen Unterscheidung von Symbolen und Zeichen (s.o. Zitat von Boden). Wir können hier scharf herausheben: Beim Computer findet keine »Symbolmanipulation« statt, sondern, wie gezeigt, Zeichenmanipulation. Die formalisierbare und regelgeleitete Zeichenmanipulation mit Hilfe des Computers ist für uns bedeutsam, denn dafür wurde der Computer hergestellt. Die "Symbolmanipulation" ist also keineswegs die Vergleichsbasis, die uns "menschliche und maschinelle Intelligenz" verstehen läßt. Die Rede von der maschinellen Intelligenz ist unserer Auffassung nach unsinnig. Menschen setzen sich mit der ihnen bedeutsamen Welt auseinander, verhalten sich in dieser, arbeiten etc. Dies können sie nur tun, weil sie sich die objektiven Bedeutungsstrukturen, die vorgefundene hergestellte und unbearbeitete Welt, kognitiv und handelnd aneignen - das macht die menschliche Intelligenz aus. Wie sollte eine entsprechende »maschinelle Intelligenz« aussehen, auf welche Welt sollte die sich beziehen?

(21) Geht man von Symbolen als Teil der objektiven Bedeutungsstrukturen aus, also von unserer Auffassung, so ist die Formulierung, daß Menschen »Symbole manipulieren«, im weitesten Sinne nicht falsch. Menschen »manipulieren« denkend Symbole, wenn sie z.B. Bedeutungen in begrifflich-sprachlicher, also symbolischer Form erfassen. Das Denken von Symbolbedeutungen ist mit dem Terminus »Symbolmanipulation« im engeren Sinne jedoch zu unspezifisch und auch irreführend bezeichnet. »Manipulation« sagt nichts über die individuelle inhaltliche Qualität des Denkens aus und legt vielmehr den Gedanken nahe, daß das symbolische Denken regelgesteuert geschehe. Die Regelsteuerung funktioniert jedoch nur auf der Zeichenebene, wie wir beim Computer gesehen hatten, und schon gar nicht beim Menschen. Obwohl manche Mächtige Untergebene gerne »regelrecht steuern« möchten - die Möglichkeitsbeziehung zur Realität können auch sie nicht außer Kraft setzen.

(22) Mit der Rede vom »Denken als Symbolmanipulation« (oder auch »menschlicher Informationsverarbeitung«) wird ein Drittstandpunkt außerhalb des Individuums eingenommen. Einen Drittstandpunkt einzunehmen bedeutet, daß über Menschen gesprochen wird, als ließe sich deren Verhalten per Ursache-Wirkungs-Schema (per »Symbolmanipulation«) erklären. Wie wir vorher dargestellt hatten, sind Menschen ihren Bedingungen nicht wie »Ursachen« unterworfen, die ein Verhalten als »Wirkung« hervorrufen. Auch hier gilt wieder, daß die Möglichkeitsbeziehung der Menschen zur Realität unhintergehbar ist. Um sie zu berücksichtigen, müssen Handlungen vom Standpunkt erster Person, vom Subjektstandpunkt untersucht werden. Nur ich selbst kann die Gründe für mein Verhalten herausfinden, von außen können Dritte darüber letztlich nur spekulieren.

(23) Sowohl die »starke KI-These«, die von der prinzipiellen Identität menschlicher kognitiver und maschinell-simulierter »kognitiver« Prozesse ausgeht[8], als auch die »schwache KI-These, die Computerprogramme als Modelle kognitiver Prozesse zur »Hypothesenprüfung« verwendet, erscheinen uns folglich unhaltbar.

(24) Mit der Symbolmanipulationsthese einher geht eine Art Perspektivenwechsel. Im Zentrum der Überlegungen stehen nicht mehr der antizipierte Programmzweck, die Benutzungsbedeutung, sondern die »Fähigkeiten des Programms«. Aus der Benutzungs- oder Mittelperspektive ("Wozu kann ich das Programm nutzen") wird eine Art »Computerperspektive« ("Was kann der Computer/das Programm?"). Ist die Mittelperspektive einmal verloren gegangen, so liegt es nicht fern, BenutzerIn und Mittel auch miteinander zu vergleichen. Die Autoren des berühmten Werks "Parallel Distributed Processing" (McClelland et al., 1986), mit dem der Wiederaufschwung der »Neuronetzforschung« maßgeblich befördert wurde, schreiben im Eröffnungsartikel "The Appeal of Parallel Distributed Processing":

(25) Computer werden als selbsttätige Agenten dargestellt, deren »Leistungen« mit denen von Menschen verglichen werden können. Nach unser Argumentation hingegen wird deutlich, daß Computer (Software etc.) gleich anderen Dingen in gesellschaftlicher Produktion für bestimmte Zwecke hergestellt werden. Sie sind also für uns bedeutsam, »bedeuten sich« aber »selbst« ebensowenig, wie »sich selbst« etwa ein Staubsauger etwas »bedeutet«. Während beim Staubsauger jedoch Leistungsvergleiche von Staubsauger und Mensch etwa bezüglich der Reinigungsleistung spontan unsinnig erscheinen, sind solche Vergleiche bezüglich beobachtbarer Leistungen beim Computer üblich. Während man weiterhin beim Staubsauger noch rasch auf den angemessenen Vergleich der »Reinigungsleistung« eines Menschen »mit« und eines Menschen »ohne« Staubsauger kommt, wird ein entsprechender Vergleich beim Computer nur selten gezogen. Ein solcher Vergleich wäre im Resultat ja auch trivial, denn Computer sind eben dazu gemacht, daß Menschen mit ihnen Aufgaben besser erledigen können als ohne sie.

(26) Grundlage für eine angemessene Betrachtungsweise ist die Fassung des Mensch-Computer-Verhältnisses als BenutzerIn-Werkzeug-Verhältnis wie in Kapitel 3.2. entwickelt. Dies schließt die Besonderheit des Computers etwa gegenüber dem Staubsauger als Reinigungswerkzeug nicht aus, so wie dieser sich wiederum bezüglich der Funktion und Möglichkeiten vom Hammer unterscheidet. Alle computertechnischen Systeme, die Menschen entwickeln, tun nichts »selbst« - auch wenn es umgangssprachlich üblich und auch unproblematisch ist, etwa davon zu sprechen, daß »sich« die Straßenbeleuchtung »von selbst« anschaltet, wenn es dunkel wird. Wir können zwar den Computer verwenden, um Bitmustern Symbolbedeutungen zuzuordnen ("speichern"), dem Computer »selbst« bedeuten diese jedoch nichts, so wie »der Uhr« die Uhrzeit nichts »bedeutet«. Bedeutsam sind gespeicherte Informationen nur für uns, »im« oder »auf dem« Computerspeichermedium sind es bloß Zeichen.

(27) Die hier entwickelte Kritik an der zeitgenössischen Informatik läßt sich wie folgt zusammenfassen und zuspitzen:

(28) 1) Die Herkunft von Bedeutungen ist in der Informatik weitgehend ungeklärt. Bedeutungen sollen durch einen Akt der Zuweisung entstehen, woran aber erkenntlich ist, welche Dinge welche »Bedeutungen« erhalten sollen, bleibt unerfindlich. Diese Zuordnungshypothese wird insbesondere auch für Symbolbedeutungen auf der sprachlichen Ebene angenommen.

(29) 2) Konsequenz der Zuordnungshypothese für symbolische Bedeutungen ist eine Vermischung von Symbolen und Zeichen. Da alle Bedeutungen nur durch Zuweisung entstehen, muß alles vor der Zuweisung bedeutungslos gewesen sein - auch »Symbole«.

(30) 3) Die Vermischung von Symbolen und Zeichen als Konsequenz der Zuordnungshypothese liegt nahe, da in der Informatik mit Konventionen gearbeitet wird, innerhalb derer Substitutionen von Zeichen stattfinden, die Träger von Programmierbedeutungen sind. Zuweisungen und Referenzierungen sind notwendige Operationen bei der Programmerstellung - sie werden jedoch unzulässigerweise verallgemeinert. Daraus resultiert ein problematisches Syntax-Semantik-Konzept, bei dem angenommen wird, Bedeutungen der Welt ließen sich vom Programm aus erreichen bzw. abbilden.

(31) 4) Letzteres ist das Programm der KI-Forschung. Dieses Vorhaben geht einher mit einer Art »Perspektivenwechsel«: Von der Perspektive des antizipierten Zwecks, also der Benutzungsperspektive, wird zu einer Art »Programmperspektive« oder »Computerperspektive« gewechselt. Das System erhält eine Art »Subjektstatus«, wird zur einer Art »selbsttätiger Agent«, womit der Mittelcharakter der Computertechnik verloren geht. Ein ähnliches Phänomen wurde auch in der kognitiven Psychologie beobachtet und mit "System-Akteur-Kontamination" (Herrmann, 1982) bezeichnet, andere Autoren sprechen in dem Zusammenhang sogar vom "Animismus" (z.B. Krojer, 1991, etwa: Glaube an eine Seele in den Dingen, z.B. "Die Wolke weint"). Voraussetzung für die Nutzung von Computertechnik als Mittel der Erkenntnis im Bereich der kognitiven Fähigkeiten von Menschen ist die Wahrung des Subjektstandpunkts (siehe dazu nächsten Abschnitt).

(32) [3] Engl. Originalfassung: "The following thesis (T) is generally regarded as correct:

(T) every sentence which is understandable has one (or, in case of ambiguity, several) meaning(s), and there exists a formalism - different from the sentence itself - which has the power to represent it (them).

In more technical terms, the same thesis becomes:

There exists a space S, called the space of meanings, and a mapping s which, for every element of the set E of understandable sentences, yields one or more elements of S."

(33) [4] Rekursion: Lösungsvorschrift, die wiederholt auf je kleinere gleichartige Teilprobleme angewendet wird. Der rekursive Abstieg bezeichnet den Vorgang der Anwendung einer Rekursionsvorschrift. Statt einer ?nichtverankerten Rekursion? würde man erkenntnistheoretisch von einem ?infiniten Regreß? sprechen.

(34) [5] Engl. Originalfassung: "Computers do not crunch numbers; they manipulate symbols. (...) A symbol is an inherently meaningless cipher that becomes meaningful by having assigned to it by a user, who thereafter interprets it in a particular way. Examples of symbols include road signs, maps, graphs, badges, drawings, spoken and written words in natural language, hieroglyphics, alphabetic characters in various alphabets, 'deaf and dump' signs, and numerical digits - whether the I, V, X, ... M of the Roman system, the Arabic 0, 1, 2, ... 9 of ordinary decimal arithmetic, or the 0 and 1 of the less familiar binary code."

(35) [6] Wir beschränken uns hier auf Programmiersprachen im engeren Sinne. Zur Konvention gehören auch die vorprogrammiersprachlichen formalen Analyse- und Entwurfsmethoden wie "Strukturierte Analyse / Strukturiertes Design" etc. Aus Gründen der Vereinfachung und um für NichtinformatikerInnen verständlich zu bleiben, klammern wir diese formalen Methoden aus.

(36) [7] "Klassen von Objekten" sind Objekte, die aufgrund von Merkmalen oder Eigenschaften »zusammengehören«. Fischbachs Frage zielt darauf ab, wie sich denn die »Zusammenhörigkeit« bestimmt.

(37) [8] "(D)ie Simulation eines kognitiven Prozesses ... (ist) selber ein kognitiver Prozeß, da in diesem Fall das Simulierte und seine Simulation nach denselben Prinzipien der Symbolmanipulation arbeiten." (Heyer, 1988, 36f).

(38) [9] Engl. Originalfassung: "What makes people smarter than machines? They certainly are not quicker or more precise. Yet people are far better at perceiving objects and natural scenes and noting their relations, at understanding language and retrieving contextually appropriate information from memory, at making plans and carrying out contextually appropriate actions, and at a wide range of other natural cognitive tasks. People are also far better at learning to do things more accurately and fluently through processing experience. (...) In our view, people are smarter than today's computers because the brain employs a basic computational architecture that is more suitable to deal with a central aspect of the natural information processing tasks that people are so good at."

Zurück: 3.2. Bedeutungen in der Menschheitsentwicklung

Vor: 3.4. Bedeutungen und »Neuronale Netze«